text=阪野 美穂 日本IBM

AI倫理とは何か

AI倫理の話題に入る前に、倫理という言葉について注目したい。「それは倫理的に看過されるべきではない」などの言い回しを耳にすることはあるものの、倫理とは何かについて明確に答えられる人はそう多くないのではないか。

倫理にはさまざまな定義があるが、技術者倫理の第一人者であるMichael Davisは「ある社会集団の行動規範」と定義している(*1)。すなわち、ある社会集団内において、ある行動の善悪を判断するための判断基準全般を指す。

この定義に従うとAI倫理は

「ある社会集団においてAIを活用する上での善悪の判断基準全般」

と言い換えられる。

倫理の問題の背景にあるもの

ここで、倫理の定義における「ある社会集団において」という前提部分について注目する。

一般論として、我々は成長の過程で所属する社会集団(たとえば、日本)における教育を受け、善悪の判断基準を学習する。そのため、同じ社会集団の中であればほぼ感覚的に善悪の判断ができる。

ところが、社会集団という前提部分が変化するとその判断が難しくなる。ある国で倫理的に問題がないとされた判断が、別の国では倫理的に看過されなくなるといった事例はよくある。また、同じ社会集団であっても時間の経過とともに社会集団が変化する可能性もあるだろう。

倫理面で問題になるような事例の背景には、

「ある社会集団において」という前提部分が崩れ、これまでに培ってきた判断基準が適応できない状況

という型が存在している。

そして、昨今倫理の問題がAIの判断により引き起こされる事例が発生するようになっている。代表例として2015年にGoogleの画像認識システムが黒人の写真に「ゴリラ」というタグを誤ってつけた事例(*2)や2017年にAmazonが開発したAI人材採用ツールで候補者が女性だった場合に評価を不当に下げていたため稼働停止を余儀なくされた事例(*3)などが挙げられる。

Amazonの事例を先ほどの型に当てはめると、男性が大多数を占める集団において学習データが準備されたAIを女性が半数を占める実社会にそのまま適応したため、女性を不当に低評価するという倫理的に看過しがたい判断を行った、ということになる。AIの活用による判断が人々の日々の生活に浸透してくると、このような事例は今後も増えていくだろう。

AI開発者に求められる倫理観

このような時代背景を踏まえ、技術者は愚直に技術を追求するのだけではなく、「開発しようとしているAIが人にどのような影響を与えうるのか」という倫理的な側面も考慮することが求められている。「それは技術者の役割ではなく、倫理の専門家の仕事だ」という意見もあるかもしれない。ただ、AI倫理に関しては、データのセキュリティ保持や各種評価指標の監視など、リスクへの打ち手を考える際に技術者のスキルが必要な部分が多く、倫理のスペシャリストだけでカバーしきれるものではない。

AIやクラウド関連技術が爆発的進化を遂げ、自らが開発したモデルが即時デプロイされて地球の裏側で何千万ものオーディエンスに影響を与える、といったことも珍しいことではない。AI開発者自らの意思判断が社会や環境に多大なインパクトを与えうる時代であり、技術者としての倫理観が問われているのだ。ビジネスにおけるAI倫理の実践には、組織としてのガバナンス整備やプロセス整備といったハイレベルな施策も必要だが、開発者自身が受け身ではなく主体的に倫理的なAIの開発のために何をすべきなのかを理解し実践していくことが重要である。

倫理的なAIの開発のために開発者に求められているのは下記の2つである。

1.倫理的なリスクの特定

2.リスク低減のためのアクション検討

2についてはさまざまなガイドラインやツールキットが存在するため詳細な解説はそちらに譲り概況を述べるにとどめ、本稿では1のアプローチを中心に解説したい。

倫理的なリスクの特定

冒頭に述べたとおり、自身が持つ判断基準が適応できないとき、倫理の問題が発生する。倫理リスクを特定するためには、そのような状況を必死に想像する必要があるのだが、容易ではない。それゆえ、倫理リスクは性別・人種・職種など多様性を持つチームで検討・議論することが望ましいが、たとえチームの多様性を確保できたとしても何も型がないままに検討を進めることは困難である。そこで、次項では検討のアプローチについて紹介したい。

AI倫理ワークショップによるリスク洗い出し

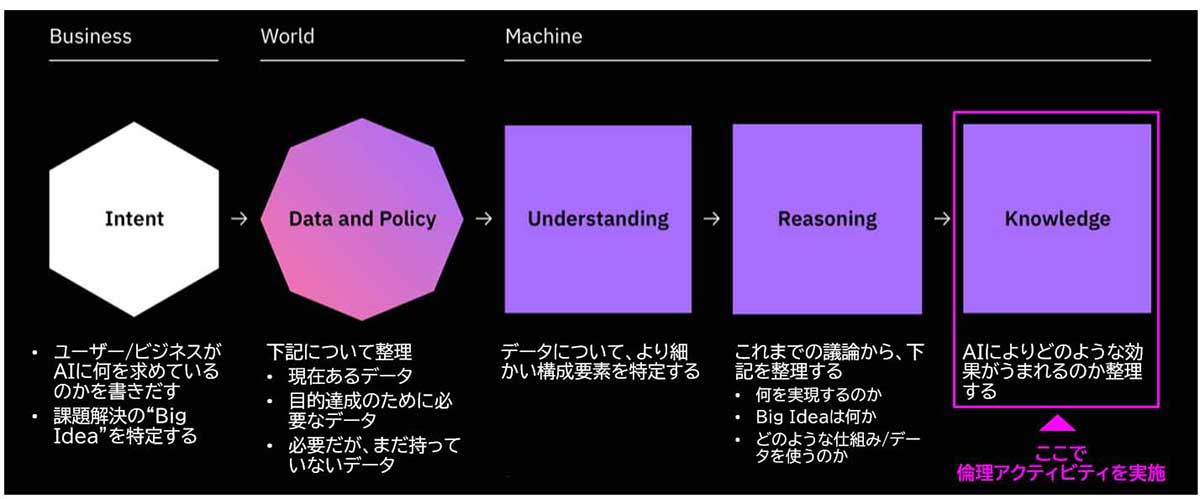

IBMではAIを活用した製品/サービス開発に特化したデザイン思考のフレームワーク「AI Essentials Framework」(*4)を開発しており、さまざまなアクティビティを提供している。アクティビティにはユーザーニーズの理解からデータやモデルの設計など、AI開発時に必要なものが含まれているが、最後のAIの効果を整理するフェーズで倫理のアクティビティを実施することが推奨されている。倫理のアクティビティをAI開発のアクティビティとあわせて実施することで開発と並行しながら倫理リスクの洗い出しや対応策の検討を実施することができる。

ワークショップ形式でのAI倫理の検討には下記のようなメリットがある。

● ユーザー視点で検討を行うことで、AI倫理リスクを幅広く洗い出せる

● 技術・営業・コンサルタントなど、スキルセットが異なるメンバーが同じ土台で対話できる

● 一堂に会することで連帯感を醸成、AI倫理の意識向上につながる

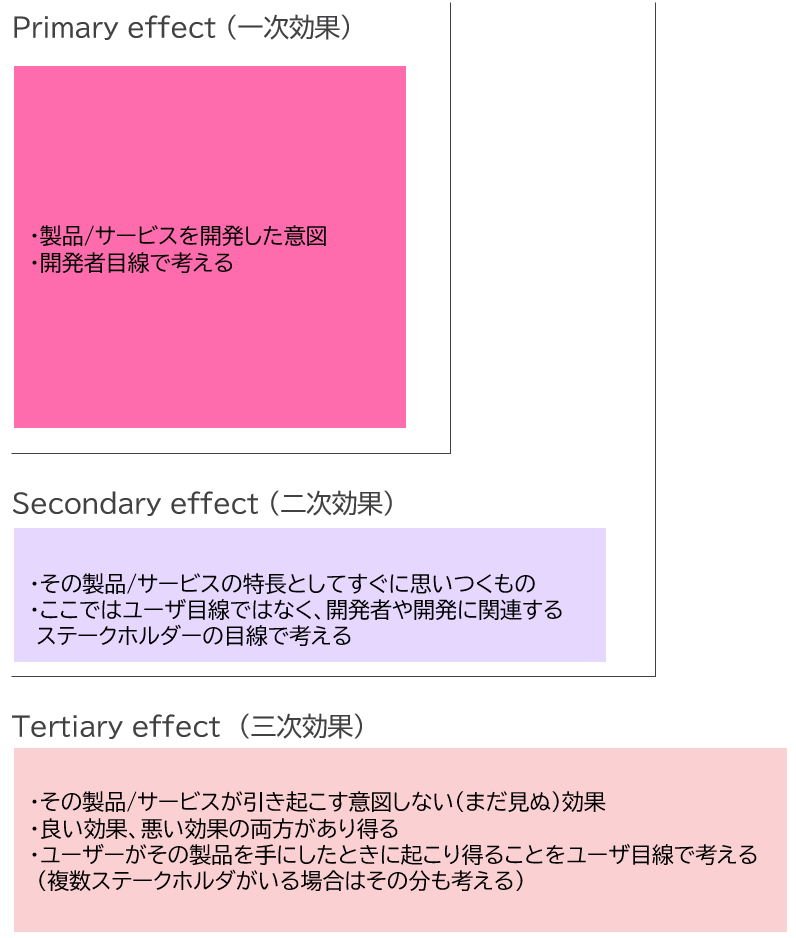

AI倫理に関するアクティビティの中から、倫理リスク洗い出しの目的で実施されるLayers of Effect(*5)をご紹介する。Layers of Effectは、ある製品/サービスがどのような波及効果を及ぼしていくのかを議論するためのフレームワークであり、3種類の効果を下記イメージのような要領で模造紙の3領域に書き出していく。

Layers of effectで書きだす3つの効果

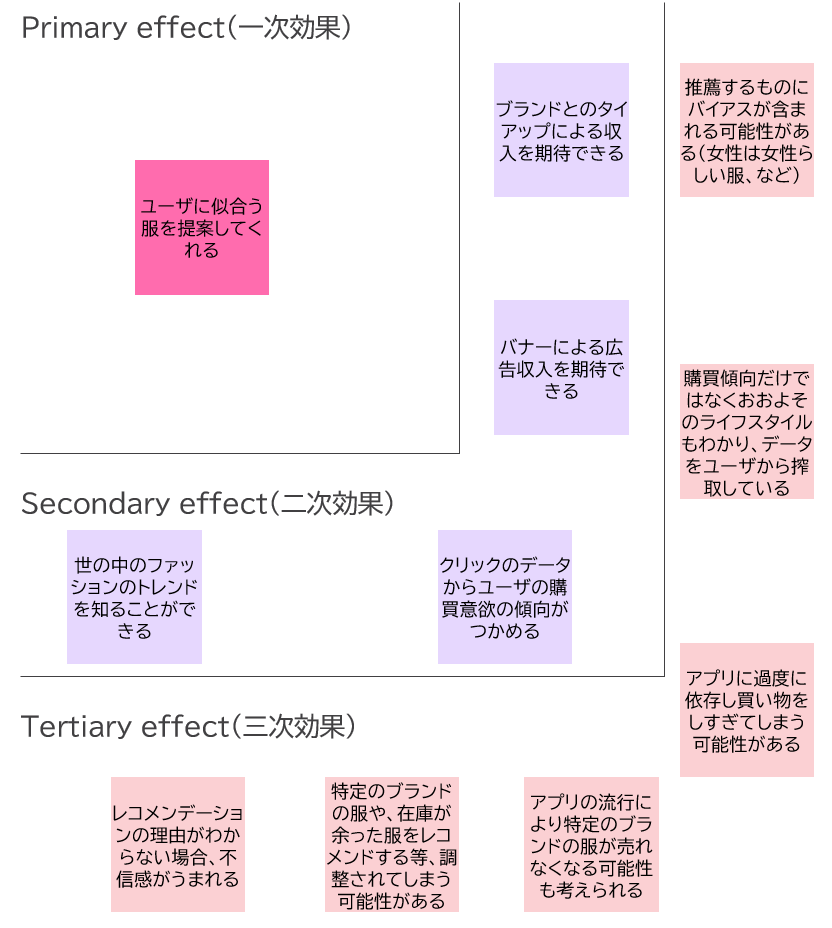

要はその製品/サービスが引き起こす効果を開発者やユーザーといった異なる視点で検討するのだが、例として、下記のような架空のファッションアプリの事例についてリスクを洗い出すというケースを考える。

● ユーザーが自分の服装の写真をアプリで撮影しアップロードするとユーザーに似合う服をレコメンドしてくれる

● レコメンドされた服が気に入った場合、リンクをクリックすることでECサイトに遷移し、そこでユーザーが服を購入することができる

筆者が上記の事例について一次から三次までの効果を書きだしたものは下記のようになった。

架空のユースケースでのLayers of effect実施例

この三次効果を探す作業でAI倫理リスクを見つけ出すことになる。コツはユーザーの気持ちになりきることなのだが、ワークショップでユーザーを徹底的に理解するための共感マップというアクティビティを併せて実施することでリスク洗い出しがしやすくなる。とはいえ、膨大な可能性の中からリスクを検討していくのは容易ではない。そこで、次に検討の際の着眼点を次項でいくつか紹介する。

AI倫理リスクのカテゴリ

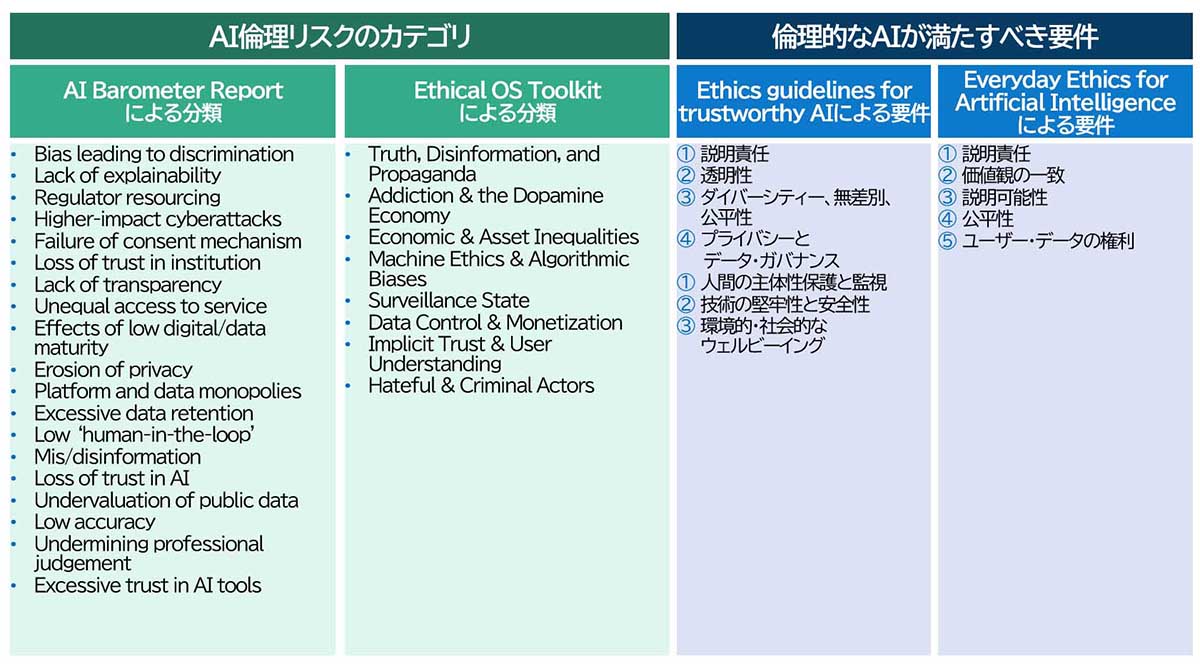

近い将来AIがどのような倫理問題を引き起こしうるかということについては、行政機関やアカデミアを中心に議論・検討されてきた。一例として、英国のデジタル・文化・メディア・スポーツ省に設置されたデータ倫理・イノベーションセンターが2020年に公表した「AI Barometer Report」(*6)という報告書のAI倫理リスクの分類が挙げられる。彼らは報告の中で、起き得る倫理リスクのカテゴリを整理し、司法、金融、エネルギーおよび公共事業といった産業別に、リスクを高中低の3段階で評価している。そのほかには、カリフォルニア州パロアルトのシンクタンクであるInstitute of the FutureとeBayの創業者によって設立された投資会社オミダイア・ネットワークが公開している「Ethical OS Toolkit」(*7)で提示された8領域のリスクカテゴリも挙げられる。

倫理的なAIが満たすべき要件

AIの倫理リスクのカテゴリではなく、AI倫理原則で規定された「倫理的なAIが満たすべき要件」の観点でリスクを洗い出す方法もある。欧州委員会のAIハイレベル専門家グループにより2019年に公開された「Ethics guidelines for trustworthy AI」(*8)では、Trustworthy AI(信頼できるAI)の要件として7要件を挙げている。

また、IBMから公開されている「Everyday Ethics for Artificial Intelligence」(*9)では倫理的なAI開発のためのアクションを5つの観点で記載している。

これまでに述べた三次効果検討の際の着眼点をまとめると、下記のようになる。

これら各カテゴリ/要件におけるリスク検討を行うことで、考慮漏れが少なくなる。先に述べたGoogleやAmazonの事例があまりにセンセーショナルであったために、AI倫理=公平性というイメージが強いが、AI倫理で考慮すべきなのは公平性だけではない。特に、AIの判断への過剰な信頼や中毒性、環境的・社会的なウェルビーイングなどについては、企業の利益追求とのジレンマが起こり得る領域であり、今後真剣に議論されるべきと考える。

リスク低減のためのアクションの検討

リスクの特定後は、リスクを低減させるためのアクションを検討する。すべてのリスクに対応できる便利なツールは現状存在しないので、一つ一つ打ち手を考える必要がある。

先に述べた信頼できるAIの要件の①から③(公平性、説明責任および透明性)に関してはさまざまなツールが開発されており、IBMからはAIのバイアスチェックのためのツールである「AI Fairness360」(*10)のほか、さまざまな種類のツールがオープンソースで提供されている(*11)。⑤や⑦についてはアルゴリズムではなくシステムやUI/UXの設計にかかわる話であり、⑤についてはHuman-in-the-loopというUI/UXの設計の検討、⑦についてはサステナビリティに配慮したアーキテクチャ(*12)やサービス利用の検討などのアプローチをとる。

また、昨今EUにおけるAI規制やニューヨーク市議会による人材雇用へのAI活用に対する規制をはじめとして、各国における規制導入が加速化している。そのような背景で各国で倫理的なAI開発のためのガイドライン整備が進みつつある。たとえば、シンガポール政府から公開された「AIガバナンスフレームワーク」(*13)では、組織におけるガバナンス構造から開発・運用時の考慮すべき事項、UI/UXの設計にまで踏み込んだ実践的なガイドラインを提供している。

一方、日本においては罰則を伴うAI倫理に関する法規制が存在せず、ソフトローアプローチ(ガイドラインや開発基準等、法的拘束力をもたないものでゆるやかに規制するアプローチ)がとられていることもあり、ガイドライン整備は途上段階にある。

公表されているガイドラインの中で実務に即したものの例を挙げると、総務省のAIネットワーク社会推進会議が2018年に策定した「AI利活用ガイドライン」(*14)では、同じく2018年に策定された「AI利活用原則」の観点で倫理的なAI利活用のためにとるべきアクションについて記載している。

また産総研らが中心となり策定した「機械学習品質マネジメントガイドライン」(*15)は、機械学習モデルの品質を5つの外部品質と9つの内部品質とで規定しており、その外部品質は、危害や危険を回避するための「リスク回避性」、有用性を示す「AIパフォーマンス」に加えて、倫理の観点での「公平性」、個人の権利を保護する「プライバシー」、悪意のある攻撃からAIシステムを守る「AIセキュリティ」から構成される。AI倫理も含めてAIの品質を体系的に整理・規定した有益なガイドである。ただ、すべてのユースケースに当てはまるone-size-fits-allのガイドラインは存在しないので、リスク低減のアクションはAI開発者が個別に考える必要がある。

社会のウェルビーイングと

企業の成長を促すために

これまでに述べてきたようにAI倫理は公平性だけではなく、プライバシーから社会としてのウェルビーイングまで含めた広範な概念であり、「AI倫理に配慮しようとすると、さまざまなガイドラインや規範に縛られ、イノベーションや利益追求の足かせになる」というイメージを持たれたかもしれない。

しかし、倫理観を抜きにしたイノベーションが社会にとっての幸福を生み出さないことはすでに歴史が証明しているところであり、また、エシカル消費という単語に代表されるように、購買の際に社会課題を意識するようになるなど消費者側の意識の変革が起こりつつある。企業がAI倫理を実践することは社会にとってのウェルビーイングと企業自身の成長につながるものであり、そのためにはAI開発者一人一人がAI倫理を意識することが重要である。本稿がAI倫理についての理解を深めるための一助となれば幸いである。

(*1)Davis, Michael. “Thinking like an engineer: Studies in the ethics of a profession.” (1998).

(*2)https://www.bbc.com/news/technology-33347866

(*3)https://www.reuters.com/article/us-amazon-com-jobs-automation-insight-idUSKCN1MK08G

(*4)https://www.ibm.com/design/ai/team-essentials/

(*5)https://www.designethically.com/layers

(*6) https://bit.ly/3DL0SmC

(*7)https://ethicalos.org/

(*8)https://www.aepd.es/sites/default/files/2019-12/ai-ethics-guidelines.pdf

(*9)https://www.ibm.com/watson/assets/duo/pdf/everydayethics.pdf

(*10)https://aif360.mybluemix.net/

(*11)https://research.ibm.com/topics/trustworthy-ai#tools

(*12)https://aws.amazon.com/jp/blogs/news/sustainability-pillar-well-architected-framework/

(*13)https://www.pdpc.gov.sg/-/media/Files/PDPC/PDF-Files/Resource-for-Organisation/AI/SGModelAIGovFramework2.pdf

(*14)https://www.soumu.go.jp/main_content/000637097.pdf

(*15)https://www.digiarc.aist.go.jp/publication/aiqm/

著者

阪野 美穂 氏

日本アイ・ビー・エム株式会社

IBMコンサルティング事業本部

AI&アナリティクス

アソシエート・パートナー

大学院でバイオインフォマティクスを研究した後、新卒でSIerに入社、製薬会社向けのバイオインフォマティクス・統計解析関連のコンサルティング業務に従事。その後、外資系コンサルティング会社に転職し、データサイエンティストとして機械学習/最適化に関連する技術の提供を行う。日本IBMに入社後はデータ分析のビジネス課題への適応をミッションとして、クライアント課題とデータ分析技術をつなぐ役割を担う。2022年からは日本IBM AI倫理チームのメンバーとして、日本企業のAI倫理意識向上に向けた活動に取り組んでいる。

*本記事は筆者個人の見解であり、IBMの立場、戦略、意見を代表するものではありません。

当サイトでは、TEC-Jメンバーによる技術解説・コラムなどを掲載しています。

TEC-J技術記事:https://www.imagazine.co.jp/tec-j/

[i Magazine・IS magazine]