IBMは6月13日にブログで、「基盤モデルに関する政策立案者への提言」を公開した。

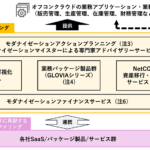

「汎用AI」とも呼ばれる基盤モデルは、下流のさまざまなタスクに適応できる大規模なAIモデルであり、AI開発の新たなパラダイムとして注目されている。IBMが新たに発表した「IBM watsonx」は、企業ユースに向けた基盤モデルの構築を可能にする新しいAIプラットフォームである。

これまでの機械学習によるAI開発では、用途ごとにモデルを作成するので、膨大な時間やリソースを学習に費やす点が問題であった。しかし大量かつ多様なデータによる事前学習を実施した基盤モデルであれば、個々の用途向けのAIは少量のデータで学習が可能となり、今までのような学習時間やリソースを大幅に削減できる。そこが基盤モデルの最大のメリットであろう。

このブログでは、「基盤モデルに関する政策立案者への提言」と題した同ブログでは、政策立案者に向けた形とはしているものの、解説されている基盤モデル使用時のリスク、およびこのリスクを前提としたアプローチは、新しいAIモデルを開発・導入・利用するすべての場合に当てはまるので、以下に一部を抜粋して紹介する。

基盤モデル使用時のリスク

基盤モデルの使用によるリスクは、他の種類のAIと同様だが、新たなリスクを引き起こしたり、既存のリスクを増幅させたりする可能性もある。リスクは主に、以下の3つに分類できる。

インプットに関連する潜在的なリスク

アウトプットに関する潜在的なリスク

ガバナンス全般に関する潜在的なリスク

① インプット

基盤モデルのインプット (トレーニングデータ、モデルの開発方法に影響を与えるプロセス) に関連する潜在的なリスクは、他の種類のAIとほとんど同じである。たとえばバイアス、トレーニングデータが個人を特定できる情報を含んでいるかどうか、トレーニングデータが「ポイズン」(モデルのパフォーマンスに影響を与えるために意図的に悪意を持って操作されること)されているかどうかに関連するリスクは、基盤モデルに特有ではない。

基盤モデルによって増幅されるリスクは、モデルの開発に使用されることが多い大量の未整理データに起因する傾向がある。このようなリスクには、トレーニングデータに関する知的財産権や著作権の問題 (ライセンス作品の使用など)、透明性やプライバシーの問題 (開発者や導入者がトレーニングデータに関する情報をどのように開示するか、「忘れられる権利」のようなデータ主体の権利を提供できるかどうかなど) が含まれる。

新しい種類のリスクには、AIシステムが生成したデータでモデルを訓練したり、再訓練することが含まれるが、それはこれらの訓練が望ましくない振る舞いを永続させたり、強化したりする可能性があるからだ。また、開発の際に指針とした価値観がモデルの動作に反映される可能性があるので、基盤モデルの開発方法にも注意が必要となる。

② アウトプット

基盤モデルのアウトプットに関するリスクは新しく、多くはその生成能力に起因する。たとえば、ミスアライメント(調整不良、ズレなどの意味)の懸念がある。これには、妄想 (hallucination)、すなわち虚偽でありながらもっともらしく見えるコンテンツを生成することや、有害、憎悪、または虐待的なコンテンツの生成が含まれる。

また基盤モデルは、偽情報を流したり、人を欺くコンテンツを生成するなど、悪意ある目的のために意図的に設計または使用される可能性がある。基盤モデルへの不正な攻撃に対する堅牢性も課題となる。プロンプト・インジェクション (ユーザーがモデルを騙して、実行を禁止するように制御されているタスクを実行させること) のような技術は、生成AIが提供する新しい機能に直接関連している。

③ 一般的なガバナンス

基盤モデルは、その開発・導入方法に関連して、いくつかの新しいガバナンスの課題を提起している。

まず、サイズが大きいほどモデルの性能が高まるが、その開発と運用には非常に大きな計算リソースとエネルギーが必要になる。

次に、AIの開発者と導入者の関係が複雑であるため、AIのバリューチェーンに沿ってどのように責任を割り振るべきかについて、混乱を招く可能性がある。たとえば、一般的なビジネスモデルでは、開発者が導入者に基盤モデルを提供し、導入者は実際のアプリケーションの特定のユースケースに合わせてモデルを微調整してから導入する。パフォーマンス上の問題が確認された場合、どこに是正措置を講じるべきか、また誰がその責任を負うべきかを判断するのかが困難となるケースが考えられる。

そして最後に、このバリューチェーンが複雑であるため、基盤モデルやその下流のアプリケーションの所有者を決定することが困難となる場合も想定される。

リスクに基づくアプローチ

AIガバナンスの重要な原則の1つは、政策立案者がAIシステムを規制するためにリスクベースのアプローチを採用することである。

AIの用途が異なれば、危害をもたらす可能性は大きく異なる。規制の義務は、関連するリスクのレベルに比例したものであるべきだ。

たとえば、消費者にテレビ番組を勧めるためのAIシステムであれば、危害を加えるリスクはほとんどないが、求人の応募を審査するAIシステムは、その人の経済的機会に多大な影響を与える可能性がある。

後者の場合、システムが求職者を不当に差別するリスクを低減するために、透明性、正確性、公平性についての高い基準が適切だろう。前者の場合は、そのような要件はほとんど利益をもたらさない。

世界中の政策立案者がこのようなアプローチを支持しており、AIガバナンスのための主要な政策フレームワークでは、AIシステムがもたらすリスクのレベルに基づいて監視を優先している。それにはたとえば以下が挙げられる。

EUの場合

欧州連合 (EU)のAI規則案は、AIシステムがもたらす可能性のあるリスクを、その用途に応じて、「許容できないリスク」から「低リスクまたは最小リスク」までの階層に分けて定めている。規制義務は、脆弱な集団を搾取する可能性が大きいシステムの全面的な禁止や、基本的人権に影響を与えるシステムに対するデータ・ガバナンス、透明性、人間の監視の要件など、異なる文脈でリスクレベルに比例して作成されている。

米国の場合

米国では、米国国立標準技術研究所 (NIST) のAIリスクマネジメント・フレームワークは、リスクの優先順位付けの原則を中心としており、より高いリスクをもたらすAIシステムにはより強いリスク管理が必要であるとしている。またAIシステムがもたらすリスクは、それが導入される場所や方法によって、文脈が非常に異なることも認識されている。このフレームワークは、正式な規制義務を定めるものではないが、責任あるAIガバナンスの現実的な実践例から情報を得て、将来の政策立案の基礎とするのに役立つ。

シンガポールの場合

シンガポールでは、規制当局が「人工知能ガバナンスのモデル・フレームワーク」を開発し、企業が適切なガバナンス対策を講じた上でAIシステムを導入できるよう支援している。このフレームワークは、リスクベースのアプローチを用いて、AIに対するステークホルダーの信頼を促進するための最も効果的な機能を特定するとともに、潜在的なAIの有害なリスクと深刻度は、その適用の文脈によって異なることを認識している。

AIシステムがもたらすリスクに合わせた規制を行うことで、高いレベルの保護を的確に適用しつつ、柔軟でダイナミックな規制の枠組みを可能にする。不必要な規制の負担を最小限に抑え、経済全体へのAIの導入率を高め、基礎となる技術に関係なく、強固な消費者保護を確保できる。また、技術に対する中立性は、あらゆる規則制定が将来にわたって有効であることを保証するものであり、極めて重要である。

基盤モデルの普及と、それらがAIのバリューチェーンにもたらす複雑性に伴い、リスクベースのアプローチから逸脱することを求める意見もある。つまり彼らは、基盤モデルは多種多様な用途に適応可能であり、その中には有害または高リスクなものもあり、技術そのものが高リスクであると考えるべきだと主張している。

そして、基盤モデルを用いて構築されたAIシステムの導入者は、必ずしも基盤モデルの開発をコントロールしているわけではないのだから、(彼らだけが責任を負うのではなく)基盤モデルの開発者も下流アプリケーションの規制義務を満たすための責任の一部を負うべきであると主張している。この意見は、重大な誤りであろう。

リスクベースのアプローチにより、導入するAIシステムが基盤モデルを使用しているか否かにかかわらず、特定のユースケースに関連する規制要件に準拠していることを保証する責任を、AI導入者は理解すべきである。

もし、導入者がリスクの高い状況で基盤モデルを導入する場合、そのために必要なあらゆる義務を遵守する必要がある。導入者は、このような必要性を開発者に伝え、適切な安全策を講じることができる。開発者は、潜在的なアプリケーションをすべて予測はできず、考えられるすべてのリスクを特定し、軽減することはできないため、下流のアプリケーションについて開発者に責任を負わせることは、コンプライアンスを不可能にすることにつながる。恣意的に大きな規制負担を課すことは、技術革新を妨げ、低リスクの領域で技術が提供できる利益を制限することになる。

このあとコラムは、政策立案者が基盤モデルに関する懸念に有意義に対処する最善の方法として、AI政策の枠組みをリスクベースで、AIシステムの導入者に適切に焦点を当てたものにすべきである、と指摘する。

政策立案者が、基盤モデルがもたらす新たなリスクに対処する生産的な方法は、①透明性を促進する、②柔軟なアプローチを活用する、③異なる種類のビジネスモデルを区別する、④新たなリスクを注意深く研究する、などであると指摘している。

コラム全文は以下から。

◎A Policymaker’s Guide to Foundation Models(英語)

◎基盤モデルに関する政策立案者への提言(日本語)

[I Magazine・IS magazine]